Saturs

- Lielie dati ir nestrukturēti vai daļēji strukturēti

- Nav jēgas glabāt lielos datus, ja mēs tos nevaram apstrādāt

- Kā Hadoop atrisina lielo datu problēmu

- Uzņēmējdarbības piemērs Hadoop

Izņemšana:

Hadoop var palīdzēt atrisināt dažas lielas datu problēmas.

Lieli dati ir ... nu ... liela izmēra! Precīzi nav precīzi noteikts, cik daudz datu var klasificēt kā lielos datus, tāpēc ļaujieties nemulsināties šajās debatēs. Nelielam uzņēmumam, kurš ir pieradis rīkoties ar datiem gigabaitos, 10 TB datu būtu BIG. Tomēr tādiem uzņēmumiem kā Yahoo petabaiti ir lieli.Tikai lielo datu lieluma dēļ nav iespējams (vai vismaz par dārgām) to glabāt tradicionālajā krātuvē, piemēram, datu bāzēs vai parastajās datnēs. Mēs runājam par datu uzglabāšanu gigabaitos. Tradicionālās datu glabāšanas failu izmantošana lielu datu glabāšanai var maksāt daudz naudas.

Šeit arī apskatiet lielos datus, to izaicinājumus un to, kā Hadoop var palīdzēt tos atrisināt.Pirmkārt, lielie dati lielākie izaicinājumi.

Lielie dati ir nestrukturēti vai daļēji strukturēti

Liela daļa lielu datu nav strukturēti. Piemēram, klikšķu straumes žurnāla dati var izskatīties šādi:laika zīmogs, user_id, page, referrer_page

Nepietiekamas struktūras dēļ relāciju datu bāzes nav labi piemērotas lielo datu glabāšanai. Turklāt ne daudzas datu bāzes var tikt galā ar miljardu datu rindu glabāšanu.

Nav jēgas glabāt lielos datus, ja mēs tos nevaram apstrādāt

Lielu datu glabāšana ir spēles sastāvdaļa. Mums tas ir jāapstrādā, lai izlūkdatus izlādētu. Tradicionālās datu glabāšanas sistēmas ir diezgan "mēmas" tādā nozīmē, ka tās vienkārši glabā bitus. Viņi nepiedāvā nekādu apstrādes jaudu.Tradicionālajā datu apstrādes modelī dati ir glabāti krātuvē, kas tiek kopēta apstrādes datorā. Rezultāti tiek ierakstīti atpakaļ krātuvē.

Šis modelis tomēr nedarbojas lieliem datiem, jo tik daudz datu kopēšana skaitļošanas klasterī var būt pārāk laikietilpīga vai neiespējama. Kāda ir atbilde?

Viens risinājums ir apstrādāt lielos datus vietā, piemēram, krātuvē, kas dubultojas kā skaitļošanas klasteris.

Tātad, kā mēs redzējām iepriekš, lieli dati ir tradicionālās glabāšanas nespējīgi. Tātad, kā mēs apstrādājam lielos datus?

Kā Hadoop atrisina lielo datu problēmu

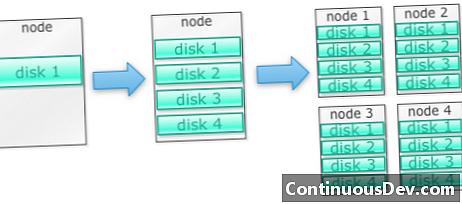

Hadoop ir izveidots, lai darbotos uz mašīnu kopasSāksim ar piemēru. Teiksim, ka mums ir jāuzglabā daudz fotoattēlu. Mēs sāksim ar vienu disku. Pārsniedzot vienu disku, mēs varam izmantot dažus diskus, kas sakrauti mašīnā. Maksimāli izlaižot visus diskus vienā mašīnā, mums jāiegūst ķekars mašīnu, katra no tām ar disku komplektu.

Tieši tā ir veidota Hadoop. Hadoop ir paredzēts darbam ar klasteru mašīnām, sākot ar piekļuvi.

Hadoop kopas mērogo horizontāli

Vairāk atmiņas un aprēķinātās jaudas var sasniegt, Hadoop klasterim pievienojot vairāk mezglu. Tas novērš nepieciešamību iegādāties arvien jaudīgāku un dārgāku aparatūru.

Hadoop var apstrādāt nestrukturētus / daļēji strukturētus datus

Hadoop neievieš shēmu datiem, kurus tas glabā. Tas var apstrādāt patvaļīgus un binārus datus. Tātad Hadoop var viegli sagremot visus nestrukturētus datus.

Hadoop kopas nodrošina glabāšanu un skaitļošanu

Mēs redzējām, kā atsevišķu glabāšanas un apstrādes kopu izveidošana nav vispiemērotākā lieliem datiem. Hadoop kopas tomēr nodrošina glabāšanu un izkliedēto skaitļošanu vienā.

Uzņēmējdarbības piemērs Hadoop

Hadoop nodrošina lielu datu glabāšanu par saprātīgām izmaksām

Lielu datu glabāšana, izmantojot tradicionālās atmiņas, var būt dārga. Hadoop ir veidots ap preču aparatūru, tāpēc tas var nodrošināt diezgan lielu krātuvi par saprātīgām izmaksām. Hadoop ir izmantots laukā petabitu mērogā.

Viens Cloudera pētījums ieteica, ka uzņēmumi parasti tērē apmēram 25 000–50 000 USD par terabaitu gadā. Izmantojot Hadoop, šīs izmaksas samazinās līdz dažiem tūkstošiem dolāru par terabaitu gadā. Tā kā aparatūra kļūst lētāka, šī cena turpina samazināties.

Hadoop ļauj iegūt jaunus vai vairāk datu

Dažreiz organizācijas neuzņem noteikta veida datus, jo to glabāšana bija pārāk dārga. Tā kā Hadoop nodrošina glabāšanu par saprātīgām izmaksām, šāda veida datus var tvert un saglabāt.

Viens piemērs varētu būt vietņu klikšķu žurnāli. Tā kā šo žurnālu apjoms var būt ļoti liels, ne daudzas organizācijas tos uztvēra. Tagad ar Hadoop ir iespējams tvert un saglabāt žurnālus.

Izmantojot Hadoop, datus varat uzglabāt ilgāk

Lai pārvaldītu saglabāto datu apjomu, uzņēmumi periodiski attīra vecākus datus. Piemēram, varēja saglabāt tikai žurnālus par pēdējiem trim mēnešiem, bet vecākus žurnālus izdzēst. Izmantojot Hadoop, vēsturiskos datus ir iespējams uzglabāt ilgāk. Tas ļauj veikt jaunu analīzi attiecībā uz vecākiem vēsturiskajiem datiem.

Piemēram, ņemiet klikšķu žurnālus no vietnes. Pirms dažiem gadiem šie žurnāli tika saglabāti neilgu laiku, lai aprēķinātu statistiku, piemēram, populārās lapas. Tagad ar Hadoop ir iespējams šos klikšķu žurnālus glabāt ilgāku laika periodu.

Hadoop nodrošina pielāgojamu analīzi

Nav jēgas visus šos datus glabāt, ja mēs tos nevaram analizēt. Hadoop nodrošina ne tikai izkliedētu krātuvi, bet arī izkliedētu apstrādi, kas nozīmē, ka mēs paralēli varam sagraut lielu datu apjomu. Hadoop aprēķināto ietvaru sauc par MapReduce. MapReduce ir pierādīts petabaitu mērogā.

Hadoop nodrošina bagātīgu analītiku

Vietējā MapReduce atbalsta Java kā galveno programmēšanas valodu. Var izmantot arī citas valodas, piemēram, Ruby, Python un R.

Protams, pielāgota MapReduce koda rakstīšana nav vienīgais veids, kā analizēt datus Hadoop. Ir pieejama augstāka līmeņa kartes samazināšana. Piemēram, rīks ar nosaukumu Pig izmanto angļu valodu, piemēram, datu plūsmas valodu, un tulko tos MapReduce. Vēl viens rīks Hive ņem SQL vaicājumus un tos palaiž, izmantojot MapReduce.

Biznesa informācijas (BI) rīki var nodrošināt vēl augstāku analīzes līmeni. Šim analīzes veidam ir arī rīki.

Šis saturs ir izvilkums no Marka Kerznera un Sujee Maniyam filmas "Hadoop Illuminated". Tas ir pieejams, izmantojot Creative Commons Attribution-nekomerciāls-ShareAlike 3.0 Unported License.